大语言模型应用如何实现端到端优化?

作者:系统组(上海) 编者按:基于大语言模型(LLMs)开发的应用目前主要使用公共 LLMs 服务提供的 API 进行,但是这些 LLMs 服务的 API 设计以请求为中心,缺乏应用级信息,难以有效优化整个应用流程,影响任务的端到端性能。为此,微软亚洲研究院的研究员们开发了一个专注于 LLMs 应用端到端体验的服务系统 Parrot,它具有减少网络延迟、提高吞吐量、减少冗余计算等优势。Parrot...

Tracing the path to self-adapting AI agents

| Ching-An Cheng, Adith Swaminathan, and Allen Nie

Introducing Trace, Microsoft and Stanford University's novel AI optimization framework, now available as a Python library. Trace adapts dynamically and optimizes a wide range of applications from language models to robot control.

Awards | Stealing Part of a Production Language Model

ICML 2024 Best Paper Award

"Stealing Part of a Production Language Model" written by A. Feder Cooper et al. receives ICML 2024 Best Paper Award.

LSR-MP:突破分子模拟瓶颈,探索知识引导的AI范式

作者:科学智能中心 编者按:分子动力学模拟在新药开发、材料设计等领域发挥着重要作用。近年来机器学习技术的不断发展,使得其对分子间相互作用的刻画也更加精确,但却面临着随分子体系扩大,计算效率降低和长程信息丢失的难题。在此背景下,微软研究院科学智能中心同耶鲁大学、西安交通大学提出了一种名为 LSR-MP 的新型分子动力学机器学习框架。该框架结合了物理洞见和几何深度学习,通过在原子/分子片段上分别建模短...

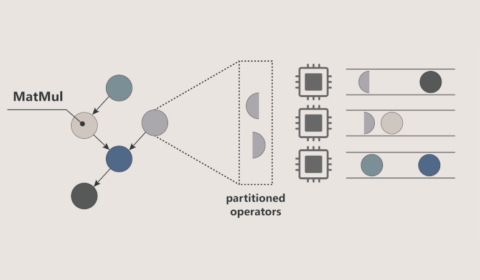

nnScaler:重塑深度学习并行策略,大幅提升训练效率

作者:苗又山 编者按:深度学习技术已经在图像识别、语音识别、自然语言处理、搜索推荐等多个领域不断展现出巨大的应用价值。然而,随着模型规模的不断增大,深度学习模型的训练变得耗时且昂贵,设计最优的并行策略组合以提高其在多设备上的执行性能是目前该领域的一大挑战。在此背景下,微软亚洲研究院提出 nnScaler 技术,通过一套并行化原语和策略限定搜索的方法来寻求最佳的并行策略组合。这一尝试为寻求深度学习并...

Microsoft at ICML 2024: Innovations in machine learning

The competitive dynamics of AI agents and a method for learning and applying temporal action abstractions represent just some of Microsoft’s contributions to ICML 2024.

In the news | Monocle

Meet the Writers, Juan M Lavista Ferres on AI for Good

In Microsoft’s pioneering AI For Good Lab, data scientists and researchers’ use of artificial intelligence (AI) is helping to tackle disinformation, predict wildfires, track whales and even detect leprosy in vulnerable populations. But what are the dangers in AI being…

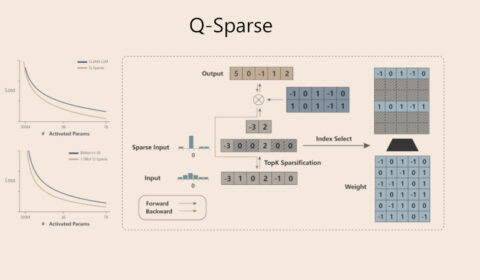

完全激活稀疏大模型,Q-Sparse突破LLM推理效能

作者:量子位 编者按:激活稀疏性是解决大语言模型(LLMs)在推理阶段出现的计算成本高、内存占用大等问题的有效方法,可以有效减少激活张量中激活元素的数量。然而该方法无法实现 LLMs 激活的完全稀疏性,从而限制了推理阶段的效率提升。 对此,微软亚洲研究院提出 Q-Sparse 实现了 LLMs 激活的完全稀疏性。该研究不仅揭示了包括推理优化规模法则(inference-optimal scalin...

Awards | MistyWest

Tusher Chakraborty named a Misties Top 20 Winner

Tusher Chakraborty was recognized for the contributions to enabling data-driven farming, influencing FCC to adopt regulations on IoT in TV White Spaces, and pioneering research in satellite-based IoT communications. The Misties Awards are for top 20 individual leaders who are…