Đưa AI dịch sang các thiết bị cạnh Microsoft Translator

Vào tháng 2016, Microsoft mang lại lợi ích của dịch máy AI-Powered, aka dịch máy thần kinh (NMT), cho các nhà phát triển và người dùng cuối như nhau. Tuần trước Microsoft mang lại khả năng NMT cho các cạnh của đám mây bằng việc tận dụng NPU, một bộ xử lý AI-chuyên dụng được tích hợp vào Bạn đời 10, Điện thoại hạm mới nhất của Huawei. Chip mới làm cho bản dịch AI-Powered có sẵn trên thiết bị ngay cả trong trường hợp không có truy cập Internet, cho phép hệ thống để sản xuất các bản dịch có chất lượng ngang bằng với hệ thống trực tuyến.

Để đạt được điều này đột phá, các nhà nghiên cứu và kỹ sư từ Microsoft và Huawei hợp tác trong điều chỉnh bản dịch thần kinh cho môi trường máy tính mới này.

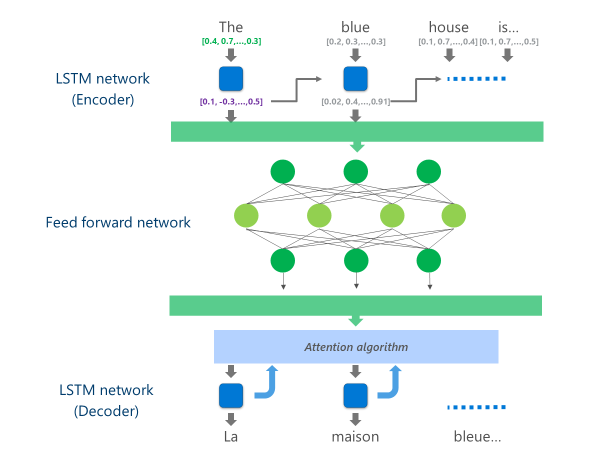

Các hệ thống NMT tiên tiến nhất hiện đang được sản xuất (tức là được sử dụng ở quy mô trong đám mây bởi các doanh nghiệp và ứng dụng) đang sử dụng kiến trúc mạng nơ-ron kết hợp nhiều lớp Mạng LSTM, một thuật toán chú ý, và một lớp dịch (Decoder).

Các hoạt hình dưới đây giải thích, một cách đơn giản, làm thế nào đa lớp chức năng thần kinh mạng. Để biết thêm chi tiết, vui lòng tham khảo "Trang dịch máy là gì"trên trang web của Microsoft Translator.

Trong triển khai NMT đám mây này, các lớp LSTM trung này tiêu thụ một phần lớn năng lượng máy tính. Để có thể chạy đầy đủ NMT trên một thiết bị di động, nó là cần thiết để tìm một cơ chế mà có thể làm giảm các chi phí tính toán trong khi bảo quản, càng nhiều càng tốt, chất lượng dịch thuật.

Đây là nơi mà các đơn vị xử lý thần kinh của Huawei (NPU) đi vào chơi. Các nhà nghiên cứu và kỹ sư của Microsoft đã lợi dụng npu, được thiết kế đặc biệt để vượt trội ở các tính toán ai có độ trễ thấp, để offload hoạt động mà có thể đã được chạy quá chậm để xử lý trên CPU chính.

Thực hiện

Việc thực hiện bây giờ có sẵn trên ứng dụng Microsoft Translator cho Huawei mate 10 tối ưu hóa dịch bằng offloading các nhiệm vụ chuyên sâu điện toán nhất cho NPU.

Cụ thể, việc thực hiện này thay thế các lớp mạng LSTM giữa mộtEED-Forward mạng nơ-ron. Nguồn cấp dữ liệu sâu-Forward mạng nơ-ron là mạnh mẽ nhưng đòi hỏi một lượng rất lớn tính toán do sự kết nối cao giữa các tế bào thần kinh.

Mạng nơ-ron chủ yếu dựa vào ma trận multiplications, một hoạt động mà không phải là phức tạp từ một quan điểm toán học nhưng rất tốn kém khi thực hiện ở quy mô cần thiết cho một mạng lưới thần kinh sâu. Huawei NPU vượt trội trong việc thực hiện các multiplications ma trận trong một thời trang ồ ạt. Nó cũng là khá hiệu quả từ một quan điểm sử dụng năng lượng, một chất lượng của pin thiết bị hỗ trợ.

Tại mỗi lớp của mạng lưới nguồn cấp dữ liệu này, NPU tính cả đầu ra tế bào thần kinh nguyên liệu và tiếp theo Chức năng kích hoạt ReLu hiệu quả và có độ trễ rất thấp. Bằng cách tận dụng bộ nhớ tốc độ cao trên NPU, nó thực hiện các tính toán song hành mà không cần phải trả các chi phí cho truyền dữ liệu (tức là, làm chậm hiệu suất) giữa CPU và NPU.

Khi lớp cuối cùng của mạng nguồn cấp dữ liệu sâu-Forward này được tính, Hệ thống có một đại diện phong phú của câu ngôn ngữ nguồn. Đại diện này sau đó được đưa qua một bộ giải mã LSTM "trái sang phải" để sản xuất từng từ ngôn ngữ mục tiêu, với thuật toán chú ý tương tự được sử dụng trong phiên bản trực tuyến của NMT.

Như Tuan, một kỹ sư phát triển phần mềm chính trong nhóm dịch Microsoft giải thích: "dùng một hệ thống chạy trên các máy chủ đám mây mạnh mẽ trong một trung tâm dữ liệu và chạy nó không thay đổi trên điện thoại di động không phải là một lựa chọn khả thi. Thiết bị di động có giới hạn trong điện toán, bộ nhớ, và sử dụng điện mà các giải pháp đám mây không có. Có quyền truy cập vào NPU, cùng với một số tinh chỉnh kiến trúc khác, cho phép chúng tôi làm việc xung quanh rất nhiều những hạn chế và để thiết kế một hệ thống có thể chạy nhanh chóng và hiệu quả trên thiết bị mà không cần phải thỏa hiệp chất lượng dịch thuật."

Việc thực hiện các mô hình dịch thuật trên chipset NPU sáng tạo cho phép Microsoft và Huawei cung cấp dịch thần kinh trên thiết bị tại một chất lượng tương đương với các hệ thống dựa trên đám mây ngay cả khi bạn đang tắt lưới.