Przynosząc tłumaczenie AI na urządzenia Edge z Microsoft Translator

W listopadzie 2016, Microsoft przyniósł korzyści z AI-Powered tłumaczenie maszynowe, aka neuronowe tłumaczenie maszynowe (NMT), dla deweloperów i użytkowników końcowych podobne. W zeszłym tygodniu Microsoft przyniósł możliwości NMT do krawędzi chmury wykorzystując NPU, dedykowany do sztucznej inteligencji procesor zintegrowany Wiązanie 10, Najnowszy flagowy telefon Huawei. Nowy chip udostępnia na urządzeniu tłumaczenia oparte na SZTUCZNEJ inteligencji, nawet w przypadku braku dostępu do Internetu, umożliwiając systemowi tworzenie tłumaczeń, których jakość jest na równi z systemem internetowym.

Aby osiągnąć ten przełom, naukowcy i inżynierowie z firmy Microsoft i Huawei współbyli ze sobą w dostosowywaniu translacji neuronowych do nowego środowiska komputerowego.

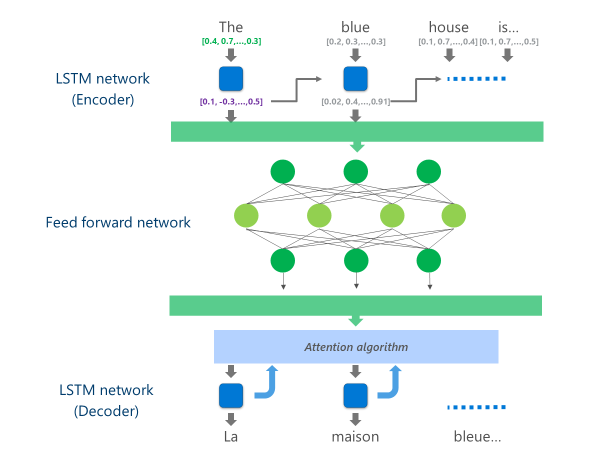

Najbardziej zaawansowane systemy NMT obecnie w produkcji (tj. używane w skali w chmurze przez firmy i aplikacje) używają architektury sieci neuronowych łączącej wiele warstw Sieci LSTM, algorytm uwagi i warstwę translacji (dekodera).

Poniższa animacja wyjaśnia w uproszczony sposób, jak działa ta wielowarstwowa sieć neuronowa. Aby uzyskać więcej informacji, zapoznaj się z "Co to jest strona tłumaczenia maszynowego"w witrynie Microsoft Translator.

W tej implementacji chmury NMT te środkowe warstwy LSTM zużywają dużą część mocy obliczeniowej. Aby móc uruchomić pełną NMT na urządzeniu mobilnym, konieczne było znalezienie mechanizmu, który mógłby zmniejszyć te koszty obliczeniowe przy jednoczesnym zachowaniu, jak najwięcej, jakości tłumaczenia.

To jest, gdzie Huawei neuronowe przetwarzania jednostki (NPU) wchodzi w grę. Naukowcy i inżynierowie firmy Microsoft skorzystali z NPU, który jest specjalnie zaprojektowany do programu Excel przy obliczeniach AI o małym opóźnieniu, do odciążania operacji, które byłyby niedopuszczalnie powolne do przetworzenia na głównym procesorze.

Implementacji

Implementacja jest teraz dostępna w aplikacji Microsoft Translator dla Huawei Mate 10 optymalizuje tłumaczenie przez odciążanie najbardziej intensywnych zadań obliczeniowych do NPU.

W szczególności ta implementacja zastępuje te średnie warstwy sieci LSTM przez głębokie fsieci neuronowe EED-Forward. Głębokie sieci neuronowe przekazywania danych są potężne, ale wymagają bardzo dużych ilości obliczeń ze względu na wysoką łączność między neuronami.

Sieci neuronowe opierają się przede wszystkim na wielokrotnych macierzy, operacja, która nie jest złożona z matematycznego punktu widzenia, ale bardzo drogie, gdy wykonywane w skali wymaganej dla takiej głębokiej sieci neuronowej. Huawei NPU wyróżnia się w wykonywaniu tych mnożeń macierzy w sposób masywnie równoległy. Jest to również dość wydajne z punktu widzenia wykorzystania energii, ważną jakość na zasilaniu bateryjnym urządzeń.

Na każdej warstwie tej sieci przesyłowej, NPU oblicza zarówno pierwotne wyjście neuron, jak i kolejne Funkcja aktywacji ReLu wydajnie i z bardzo małym opóźnieniem. Wykorzystując dużą szybkość pamięci na NPU, wykonuje te obliczenia równolegle bez konieczności płacenia kosztów za transfer danych (tj. spowolnienie wydajności) między CPU i NPU...

Po obliczeniu końcowej warstwy tej głębokiej sieci przesyłania dalej, system ma bogatą reprezentację zdania języka źródłowego. Reprezentacja ta jest następnie podawany przez od lewej do prawej LSTM "dekoder" do produkcji każdego słowa docelowego języka, z tym samym algorytm uwagę używany w wersji online NMT.

Jako Anthony Aue, główny inżynier rozwoju oprogramowania w zespole Microsoft Translator wyjaśnia: "biorąc system, który działa na potężnych serwerach w chmurze w centrum danych i działa go bez zmian na telefonie komórkowym nie jest realną opcją. Urządzenia przenośne mają ograniczenia w mocy obliczeniowej, pamięci i zużycia energii, które nie mają rozwiązań chmurowych. Posiadanie dostępu do NPU, wraz z kilkoma innymi Wariacje architektoniczne, pozwoliło nam obejść wiele z tych ograniczeń i zaprojektować system, który może działać szybko i sprawnie na urządzeniu bez konieczności kompromisu jakości tłumaczenia."

Implementacja tych modeli tłumaczeń na innowacyjnym chipsecie NPU umożliwiła firmie Microsoft i Huawei dostarczanie translacji neuronowych na urządzeniu w jakości porównywalnej z systemami opartymi na chmurze, nawet gdy jesteś poza siecią.