Föra AI-översättning till Edge-enheter med Microsoft Translator

I november 2016, Microsoft förde fördelen av AI-powered maskin översättning, alias neurala maskin översättning (NMT), till utvecklare och slutanvändare likadana. Förra veckan Microsoft förde NMT kapacitet till kanten av molnet genom att utnyttja NPU, en AI-dedikerad processor integreras i Kompis 10, Huaweis senaste flagg skepp telefon. Den nya chip gör AI-powered översättningar tillgängliga på enheten även i avsaknad av Internet uppkoppling, vilket gör det möjligt för systemet att producera översättningar vars kvalitet är i paritet med online-systemet.

För att uppnå detta genombrott samarbetade forskare och ingenjörer från Microsoft och Huawei med att anpassa neurala översättningar till denna nya dator miljö.

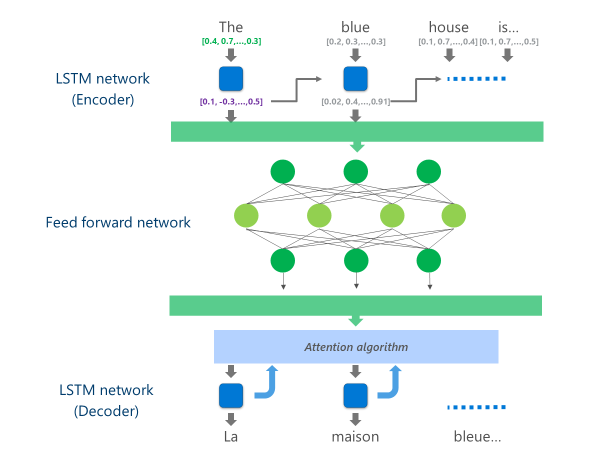

De mest avancerade NMT-system som för närvarande är i produktion (dvs., används i stor skala i molnet av företag och appar) använder en neurala nätverk arkitektur som kombinerar flera lager av LSTM-nätverk, en uppmärksamhets algoritm och ett översättnings lager (decoder).

Animeringen nedan förklarar, på ett förenklat sätt, hur detta flera lager neurala nätverk funktioner. För mer information, se "Vad är maskin översättning sida"på webbplatsen Microsoft Translator.

I den här NMT-molnimplementeringen förbrukar dessa mittersta LSTM-lager en stor del av dator kraften. För att kunna köra full NMT på en mobil enhet, var det nödvändigt att hitta en mekanism som kan minska dessa beräknings kostnader samtidigt bevara, så mycket som möjligt, översättnings kvaliteten.

Det är där Huaweis neurala Processing Unit (NPU) kommer in i spelet. Microsofts forskare och ingenjörer drog fördel av NPU, som är speciellt framtagen för att utmärka sig vid låg latens AI-beräkningar, för att avlasta operationer som skulle ha varit oacceptabelt långsamma att bearbeta på huvud PROCESSORN.

Genomförandet

Implementeringen som nu finns tillgänglig på Microsoft Translator-appen för Huawei Mate 10 optimerar översättningen genom att avlasta de mest beräknings intensiva uppgifterna till NPU.

Specifikt ersätter denna implementering dessa mitten LSTM nätverks lager av en djup fEed-framåt neurala nätverk. Djupa feed-forward neurala nätverk är kraftfulla men kräver mycket stora mängder beräkning på grund av den höga anslutningen mellan nerv celler.

Neurala nätverk förlitar sig främst på mat ris multiplikationer, en operation som inte är komplex från en matematisk synvinkel men mycket dyrt när det utförs på den skala som krävs för en sådan djup neurala nätverk. Huawei NPU utmärker sig i att utföra dessa matris multiplikationer i ett massivt parallellt sätt. Det är också ganska effektivt från ett makt utnyttjande synvinkel, en viktig kvalitet på batteridrivna enheter.

Vid varje lager av denna feed-forward nätverk, beräknar NPU både rå neuron produktionen och den efterföljande Aktiverings funktion för ReLu effektivt och med mycket låg latens. Genom att utnyttja den rikliga höghastighets minne på NPU, det utför dessa beräkningar parallellt utan att behöva betala kostnaden för data överföring (dvs., bromsa prestanda) mellan CPU och NPU.

När det sista lagret av denna djupa feed-forward nätverk beräknas, har systemet en rik representation av käll språks meningen. Denna representation matas sedan genom en vänster till höger LSTM "dekoder" för att producera varje mål språks ord, med samma uppmärksamhet algoritm som används i online-versionen av NMT.

Som Mer från Anthony Aueförklarar en huvud program utvecklings ingenjör i Microsoft Translator-teamet: "tar ett system som körs på kraftfulla moln servrar i ett Data Center och kör den oförändrad på en mobil telefon är inte ett genomförbart alternativ. Mobila enheter har begränsningar i dator kraft, minne och energi användning som moln lösningar inte har. Med till gång till NPU, tillsammans med några andra arkitektoniska tweaks, tillät oss att arbeta runt många av dessa begränsningar och att utforma ett system som kan köras snabbt och effektivt på enheten utan att kompromissa översättnings kvalitet."

Implementeringen av dessa översättnings modeller på den innovativa NPU chipset tillät Microsoft och Huawei att leverera på enheten neurala översättning på en kvalitet jämförbar med den i molnbaserade system även när du är utanför rutnätet.